отчет о тестировании приложения

Создание понятных отчетов о тестировании

Введение

Данная статья будет полезна для специалистов не только в тестировании, но и из других областей.

Я думаю, все понимают, что отчётность — это, зачастую, та часть, которая обязательна на проекте, но составлять ее всегда проблематично. Каждый, рано или поздно, сталкивается с проблемой «как это описать?», «что написать?» и главное «зачем и кто это будет читать?».

На самом деле, отчет — это важная и лаконичная форма передачи информации от исполнителя к заказчику. Это ответ на его технические требования и одновременно информация о проделанной работе.

Сегодня мы поговорим об отчетах в тестировании. В статье Вы найдет акценты на важные моменты при создании отчётов.

Понятный отчёт о тестировании

Создание понятного отчёта о тестировании (test-report) на практике.

Для начала, давайте вспомним определение:

Отчёт — это документ, содержащий информацию о выполненных действиях, результатах проведённой работы. Обычно он включает в себя таблицы, графики, списки, просто описывающую информацию в виде текста. Их пропорция и содержание определяют пользу и понятность отчета.

Нам важно понять, для кого, для чего и в каких условиях мы это делаем и на сколько это улучшит восприятие излагаемой нами информации. Надо помнить, что каждое действие преследует определенную цель. В случае отчета нам важно понять, для кого, для чего и в каких условиях мы это делаем.

Давайте посмотрим на схему:

Аналитические разрезы – это и есть наш отчет. В нем мы даем анализ нашей работе и оценку тестируемому продукту.

Вид компании, в идеальной ситуации, не должен влиять на качество и смысловую ёмкость отчетности. В реальном же мире, к сожалению, отчетность аутсорсинговых компаний является, как правило, более качественной и емкой, чем отчетность штатных отделов тестирования (бывают и приятные исключения).

Мы, как и любая другая аутсорсинговая компания, вынуждены уделять большое внимание качеству и прозрачности отчетности, потому что она является ключевой видимой заказчику метрикой оценки нашей работы.

Саму отчетность можно разделить на финальную и регулярную – дневную, недельную, месячную, версионную (для каждой версии продукта) и т.п. Различия заключаются в глубине временнОй выборки.

Итак, перед написанием отчета, сначала нам надо определиться для кого мы его пишем.

Для кого формируем отчет?

При создании отчета важно понимать, для кого он создаётся, и кто будет его читать.

Исходя из приоритетов целевой аудитории, мы должны определить, какую информацию должен содержать отчёт. Соответственно, в ходе проекта, информация должна консолидироваться по тому направлению, которое необходимо отразить.

Мы можем выделить три группы целевых аудиторий:

1. Технические пользователи — Test-manager. Для них приоритетно понимание хода тестирования, какие возникают проблемы, как они решаются, построение самого процесса тестирование, описание применяемых методов и технологий.

2. Product Manager, они же Менеджеры продукта. Их фокус сконцентрирован на сроках выполнения, выжимки из результатов тестирования без излишних технических подробностей и на общую статистику (цифровые и сравнительные метрики).

3. Бизнес-пользователи. Обычно это и есть те люди, которые принимают решения по завершению тестирования. Они же определяют качество проделанной работы. Для них, в первую очередь, важен конечный результат в максимально кратком и ясном формате (да\нет), наглядное представление информации (графики, диаграммы), экспертное мнение о возможности выпуска продукта в промышленную среду и т. п., без углубления в детали.

Вывод: Написать отчет, который устроит все группы, практически невозможно. Прежде чем писать отчет, обязательно определите целевую аудиторию. В зависимости от нее, содержание будет сильно отличаться своей структурой и содержать разные детали, необходимые конкретной группе.

Какова глубина временной выборки?

Отчёты могут делиться на два вида относительно времени:

1. (Недельный, дневной, месячный)/ промежуточный.

В общем, это практически тот же финальный отчет, но с измененными приоритетами фокуса и уменьшенной глубиной временной выборки. В нем обязательно должны содержаться две главных метрики:

— Оценка степени готовности продукта.

— Оценка проведённых работ по тестированию за время между отчетностями (прогресс).

Этот отчет должен показать какова динамика вашей работы.

Важно помнить, что прогресс – величина не постоянная, а динамическая, она определяется за счёт сравнения состояния проекта на прошлой неделе и настоящей. Соответственно прогресс – этот совокупность метрик, позволяющих понять в каком состоянии находится проект.

Они создаются для каждого проекта индивидуально, основываясь на целях, которые ставятся для успешного проведения тестирования. Метрики ставятся при создании ТК (тест-кейсов), прохождении ТК (провален\пройден), обнаружении дефектов (критичность). Они позволяют доступно и достаточно быстро составить общую сравнительную картину по проекту. Если вы, например, используете TestLink, то понимаете, что метрики позволяют делать быструю выборку по проблемам, составлять статистику проваленных ТК и т. п.

Данная информация полезна и необходима для Product Manager, её составляют и контролируют Test-manager, а также QE и SQE.

Есть еще один важный и часто используемые тип временного отчета – версионный (отчет по итерации).

Он схож с итоговым. В нём описываются те задачи, которые были выполнены командой тестирования для конкретной версии продукта.

2. Конечный /финальный.

В финальном отчете важно показать общий взгляд на проделанную работу (в контексте установленных метрик) и эволюцию продукта.

Так же, надо дать исчерпывающую информацию о статусе продукта в данный момент (количество оставшихся неисправленных ошибок, полностью ли протестирован продукт или требуется дополнительный цикл тестирования, оценка возможности выпуска продукта во «внешний мир» и т.д).

Вывод: Ведите статистику, используя метрики в течении всего проекта. Она поможет вам в нужный момент предоставить любую информацию заказчику и избавит от страха перед вопросами «А что конкретно вы сделали на четвертой неделе?» и «Что у нас со сроками?».

Какие приёмы представления информации и данных использовать в отчёте?

Когда технический специалист пишет для другого технического специалиста, вопрос о применении тех или иных приемов отражения информации возникает редко. Термины, формулы, профессиональный сленг – это привычно и понятно. Гораздо сложнее писать отчеты для людей, которые относительно далеки от специфики тестирования.

Для Бизнес-пользователей, зачастую, используют представление информации в виде графиков. Они наглядно показывают на сколько продукт готов к выпуску в промышленную среду, на сколько процентов проект выполнен.

Это может быть, к примеру, график пройденных ТК п о модулям. Он наглядно покажет, какой объем работы в каждом модуле уже проделан и поможет вычленить проблемы.

Так же, очень полезным может быть график отношения созданных тикетов (обнаруженных багов) и закрытых (исправленных багов). Не даром он является основным во многих таск-трекерах.

В случае продуктивной работы программистов над исправлением дефектов и написанием качественного кода кривая критических ошибок с выходом нового релиза стремиться к низу, при этом приоритет и важность ошибок тоже уменьшается.

Но, если разработчиками или тестировщиками уделяется мало внимания существующим дефектам, то кривая закрытых багов растет медленнее, чем не закрытых.

В идеальном случае кривая незакрытых багов (найденных, но не исправленных) должна сойтись с кривой исправленных. Другими словами, к финальному релизу необходимо, что бы все дефекты были устранены. Если это не так, то руководство может принять решение о продлении разработки и тестирования с целью устранения всех дефектов или выпустить продукт в «прод», беря на себя возможные риски.

В дополнение к графику необходимо оформлять сводную таблицу. График строится на основании этих данных.

Вот пример таблицы, на основании которой был построен график пройденных ТК по модулям:

Вывод: График для бизнес-пользователей — обязательная часть отчетности. Он информативен, доступен и понятен конечному пользователю, демонстрирует динамику активности на проекте или, в худшем случае — застой.

Так же, использование графиков в отчетах для любых пользователей и технических специалистов целесообразно тогда, когда надо быстро и наглядно сравнить цифры и показать динамику.

ЧТО НУЖНО УКАЗЫВАТЬ В ОТЧЕТЕ ВСЕГДА?

Может показаться, что отчеты разных типов сильно отличаются.

Тем не менее, в них есть схожие черты и данные, которые стоит указывать всегда.

Вот они:

1. Состав команды;

2. Сроки выполнения, за которые составляется отчет;

3. Описание процессов тестирования;

4. Изменения тестовой модели, дополнение ТК;

5. Процент пройденных ТК;

6. Критичные и блокирующие проблемы и принятые меры по их устранению;

7. Результаты регресса (плюс акцент на сохранившихся проблемах);

8. План на следующую итерацию\ неделю\ месяц;

Пункты 3, 4, 6 и 8 стоит писать с оглядкой на целевую аудиторию отчета.

Седьмой пункт стоит указывать тогда, когда проводилось «регресс-тестирование». Обычно этот пункт фигурирует в «версионных» отчетах.

Пункт 8 из итогового отчета исключается.

Заключение

Итак, мы поняли нашу целевую аудиторию, обозначили период, за который мы будем писать отчет, определили содержание и блоки. На самом деле — это практически все, что надо, чтобы сформировать понятный документ, который обязательно найдет отклик в головах тех, кому он адресован.

Пишите ваши отчеты детально, грамотно и с удовольствием, ведь хороший отчет – это как минимум треть работы и единственная ее часть, которая видна кому-то, кроме тестировщиков и программистов.

Автоматизированное создание отчета по тестированию

Введение

Так уж сложилось, что у нас в компании ведется учет работ по тестированию в небезызвестных GoogleDocs. Поскольку таким учетом занимаюсь я один, то это идеальный вариант. Плюс еще есть возможность без труда поделиться наработками с коллегами и не нужно заботиться об актуальности версий — все сохраняется моментально.

Это основные причины выбранного варианта работы. Но, как известно, у любой монеты две стороны. Минус такого подхода состоит в том, что большие проекты трудно обрабатывать и составлять вменяемые отчеты по тестированию (для этих целей, безусловно, подходят системы управления тестами).

Совсем недавно я столкнулся с Google Script. Это инструмент, позволяющий намного эффективнее работать с документами в облаке. Я решил, что он подойдет для задачи автоматизированного составления отчетов по тестированию. И вот что получилось.

Структура

В документе в виде таблицы я веду описания пользовательских сценариев для тестирования приложений. Не претендую на подробное описание, однако самая критичная информация там имеется, а именно: раздел, к которому относится сценарий, название самого сценария, шаги сценария, статус пройденного сценария, комментарии и ссылка на страницу с описанием ошибки в баг-трекере. Набор статусов у нас обычно ограничен «Реализовано», «Дефект», «Отложено». На некоторых проектах могут добавляться и другие, но не суть. Выглядит это следующим образом:

Очевидно, что такие сценарии не удобно вести на одной странице — есть смысл разбить на несколько листов (например, по этапам или релизам).

Задача

Необходимо максимально упростить жизнь тестировщика при составлении отчетов тестирования. Идеальным будет вариант, где можно посмотреть сводку по разделам и проекту целиком, а так же не только получить список ошибок и ссылки на них, но и посмотреть на общую картину.

Решение

В качестве решения я выбрал таблицу, разделенную по разделам. Каждая строка соответствует сценарию тестирования и окрашена в соответствующий цвет (для дефектов — красный, для готовых задач — зеленый, для остального — желтый). При этом подводится статистика для каждого из разделов отдельно (сколько ошибок, сколько успешных сценариев, сколько других, то же самое в процентах) и для всего проекта целиком.

Вот такой вид отчета для сценариев:

Вот что получилось для статистики:

Как же это делать?

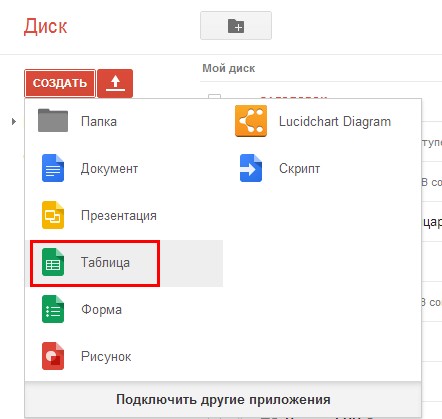

Для начала нам нужно создать скрипт внутри документа. Делается это буквально за несколько минут.

Сначала необходимо создать таблицу на диске Google.

Затем перейти в меню «Инструменты» и выбрать пункт «Редактор скриптов»

После этого выбираем пункт меню «Пустой проект», стираем код и начинаем писать свой.

Для начала напишем функцию onOpen:

Это поможет нам добавить пункт меню в панель инструментов:

Далее пишем функцию, которая будет вызываться при выборе этого пункта меню:

Ну а теперь по порядку.

Функция пробегает по всем листам открытого файла и считывает всю информацию для отчета:

Функция формирует массив для вывода в удобочитабельном виде. Тут есть одна особенность — если вы поменяли местами поля на разных листах, то ничего страшного не случится. Массив parts содержит списки разделов, по которым сгруппированы сценарии, а его элементы — имя раздела и список сценариев в виде массива:

Собственно, это и есть функция, благодаря которой не так страшно путать местами колонки на страницах сценариев:

Для создания нового листа с отчетом:

Формирование самого отчета, сбор статистики и немного оформления:

Функция вывода в отчет информации по одному разделу и формирование статистики по нему, а так же оформления для более приятного чтения:

И, наконец, финальная статистика и много оформления:

Для полноценной сборки нужны все эти функции в любой последовательности в файле скрипта.

Код не идеален — есть над чем работать, однако если кому-то это пригодится, буду рад ответить на вопросы.

Анализ результатов нагрузочного тестирования

С каждым днем в мире становится все больше и больше инструментов для проведения нагрузочного тестирования. Собственно, и сам интерес к этой теме начинает возрастать.

Основная задача инструмента нагрузочного тестирования — подать заданную нагрузку на систему. Но кроме этого есть еще одна, не менее важная задача — предоставить отчет о результатах подачи этой нагрузки. Иначе мы проведем тестирование, но ничего не сможем сказать о его результате и не сможем достаточно точно определить, с какого момента началась деградация системы.

В настоящий момент наиболее популярными инструментами тестирования являются Gatling, MF LoadRunner, Apache JMeter. Все они обладают возможностями как генерации готовых отчетов по проведенному тестированию, так и отдельных графиков или сырых данных, на основе которых строится уже сам отчет.

Прежде чем писать любой отчет, нужно понять, для кого мы его пишем и какую цель преследуем. Нет никакого смысла добавлять множество графиков времени отклика приложения в отчет по каждой операции, если ваша цель — определить, есть ли утечки памяти, зафиксирована ли нестабильная работа во время теста надежности, или если вам нужно сравнить два релиза между собой в рамках регрессионного тестирования. Для ответа на эти вопросы вам хватит всего пары графиков, если, конечно, вы не зафиксировали проблемы и не хотите в них разобраться. Поэтому, прежде чем создавать отчет, подумайте, а точно ли вам нужно добавить все графики в него или лишь наиболее показательные и дающие ответ на цель тестирования. Также набор графиков и их анализ для отчета зависят от выбранной модели нагрузки — закрытой или открытой, так как разные модели дадут разные фигуры на графиках.

Мы в Тинькофф активно используем инструмент Gatling, поэтому на его примере расскажем, как создать отчет вашей мечты и куда следует смотреть при его анализе. Также сразу хочу заметить, что почти все графики, описанные в статье, можно получать в режиме онлайн с помощью связки вашего инструмента с Grafana. Это наиболее удобный инструмент для создания отчетов «на лету», с помощью сконфигурированного заранее дашборда. Более того, это позволяет более быстро создать почти любой график на основе отправленных вами данных. Уже сейчас есть готовые дашборды почти для всех инструментов нагрузочного тестирования. Графики для других инструментов — MF LoadRunner и Apache JMeter — тоже будут приведены, их анализ строится по аналогии с Gatling.

Основные метрики

Индикаторы

Показывают количественное и процентное распределение времени отклика запросов по группам. Графики этого типа удобно использовать, чтобы дать быструю предварительную оценку результатам тестирования без более глубокого анализа остальных графиков.

Пороги для перехода из группы в группу задаются заранее на основе экспертной оценки или SLA (нефункциональных требований). Например, может быть три группы:

Метод APDEX позволяет использовать индикаторы в регрессионном тестировании для сравнения релизов: так сразу видно, насколько хуже или лучше стал релиз в общем. К сожалению, этого графика нет из коробки в MF LoadRunner и Apache JMeter, но его легко создать с помощью дашборда Grafana.

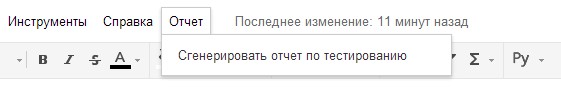

Таблица с временем отклика

По умолчанию Gatling строит таблицу по перцентилям, среднему и максимальному времени отклика, а также по ошибкам. По ней отслеживается выход за пределы SLA (превышение нефункциональных требований). Обычно в SLA указывают перцентили 95, 99 и процент ошибок. Таким образом таблица позволяет получить быструю оценку результатов тестирования.

Если группировать запросы в виде транзакций, можно увидеть в таблице как оценку отдельных запросов, так и оценку всей группы и транзакции сразу.

| HTML Gatling Report |  |

| MF LoadRunner также создает таблицу сам в блоке Analysis Summary Report и называется Transaction Summary |  |

| В Apache JMeter эти данные можно найти в Aggregate Report |  |

График Virtual Users

Обычно измеряется в штуках и показывает, как пользователи заходят в приложение, тем самым иллюстрируя реальный профиль нагрузки. Стоит сразу оговориться, что для MF LoadRunner и Gatling эти графики показывают количество Virtual Users, а для Apache JMeter — количество Thread.

График используют для контроля правильности подачи нагрузки. Необходимо, чтобы ваш расчетный сценарий соответствовал тому, что вы подали на систему в реальности. Например, если вы видите на графике большие отклонения от планируемого сценария в верхнюю сторону, значит, что-то пошло не так: ошибка в расчете, запущено больше, чем нужно, копий инструмента нагрузки и так далее. Возможно, дальнейшие графики уже нет смысла анализировать, так как вы подали на 100 пользователей больше, чем планировали, а система изначально проектировалась для работы лишь 10 пользователей.

Этот график разделяется на два вида:

| HTML Gatling Report |  |

| В MF LoadRunner этот график называется Running Vusers |  |

| В Apache JMeter график называется Active Threads Over Time и не входит в стандартную поставку, но его можно бесплатно скачать на сайте JMeter-Plugins.org |  |

График Response Time

Чаще всего измеряется в миллисекундах — показывает время ответа на запросы к приложению. Время отклика не должно превышать SLA. Этот график является основным инструментом для поиска точек деградации при проведении нагрузочного тестирования.

Если на графике видны пики, значит, в этот момент приложение не отвечало по какой-то причине — это может являться отправной точкой для дальнейших исследований. Время отклика должно быть равномерным, без пиков для всех операций на протяжении всей ступени нагрузки, а также коррелировать с увлечением нагрузки. Gatling не содержит график «чистого» (среднего, не агрегированного) времени отклика, в отличие от других инструментов.

Кроме графика времени ответа каждого запроса удобно показывать также линию с суммарным временем ответа (Total Response Time). Если наложить график подаваемой нагрузки (VU/RPS), можно отслеживать корреляцию с увеличением времени отклика от увеличения подаваемой нагрузки (VU/RPS). В Apache JMeter этот график называется Response Times vs Threads.

Далее пойдут графики, на которых может быть множество линий, каждая из которых отображает свой сценарий или запрос. Если у вас сложный тест со множеством операций и нелинейным профилем, советуем отражать в отчете лишь наиболее показательные запросы или группы запросов. Как вариант, можно отражать лишь запросы, превысившие SLA/SLO, чтобы не засорять график и отчет.

| В MF LoadRunner график называется Average Transaction Response Time и показывает среднее время для транзакций |  |

| Для Apache JMeter график существует в двух вариантах в расширенном пакете с сайта JMeter-Plugins.org и называется Response Times Over Time и, по умолчанию, Response Time Graph. Более наглядный и удобный, на мой взгляд, — первый вариант |  |

Вариации графика

Возможна модификация, в которой применяются перцентили времени отклика и добавляется линия среднего времени отклика по всем запросам. Использование перцентилей здесь будет более правильным решением, так как среднее время отклика очень чувствительно к резким выбросам.

В тестировании производительности чаще всего используется 95 и 99 перцентиль для большей наглядности. Однако, если вы все же смотрите среднее время отклика, вам стоит учитывать при этом стандартное (среднеквадратичное) отклонение.

| HTML Gatling Report |  |

| Для MF LoadRunner график будет называться Transaction Response Time (Percentile) |  |

| Также вы можете получить и перцентили для Apache JMeter с помощью графика Response Times Percentiles из этого же расширенного набора |  |

Распределение Response Time

Также есть прекрасные графики, показывающие зависимость распределения времени от количества запросов.

Этот вид графиков чем-то напоминает индикаторы, но показывает более полную картину распределения времени, без обрезки перцентилями или другими агрегатами. С помощью графика можно более наглядно определить границы для групп индикаторов. У MF LoadRunner такого графика нет.

| HTML Gatling Report для каждого запроса |  |

| Есть еще один вариант распределения времени выполнения запроса от количества запросов в разрезе успешных и ошибочных запросов для всего теста |  |

| Для MF LoadRunner данный график будет называться Transaction Response Time (Distribution) и показывать распределение для транзакций |  |

| В Apache JMeter тоже есть этот график в расширенном пакете и называется Response Times Distribution |  |

Latency

| В Apache JMeter этот график присутствует лишь в расширенном наборе и называется Response Latencies Over Time |  |

Bandwidth

Аналогично метрике выше можно выделить параметр Bandwidth (килобит в секунду) — ширину пропускания канала. Он показывает, какой максимальный объем данных может быть передан за единицу времени.

Изменяя этот параметр на инструменте нагрузки можно моделировать различные источники подключений к приложению: мобильная связь 4G или проводная сеть. В бесплатной версии Gatling этого графика нет, он есть лишь в платной версии Gatling FrontLine. Этот график из коробки есть лишь в MF LoadRunner, находится в том же блоке, что и Latency, и называется Average Bandwidth Utilization Graph.

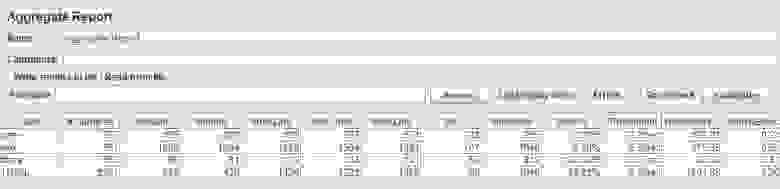

График Request Per Second

Измеряется в штуках в секунду — показывает количество запросов, поступающее в систему за 1 секунду.

График показывает, сколько запросов может выдержать ваша система под нагрузкой, и он является также основным графиком для построения отчета. По нему также отслеживается выход за пределы SLA, так как с ростом нагрузки при прохождении точки деградации или локальных экстремумов может наблюдаться провал, а затем резкий рост. Чаще всего это связано с тем, что, когда приложение начинает деградировать, запросы тоже начинают копиться на входе в приложение (появляется очередь), затем приложение выдает им какой-то ответ или запросы падают по тайм-ауту, что вызывает резкий рост на графике — ведь получен ответ.

| HTML Gatling Report |  |

| В MF LoadRunner график называется Hits per Second |  |

| Для Apache JMeter существует график Hits per Second из расширенного пакета |  |

Измеряется в штуках в секунду и показывает количество транзакций (в рамках транзакции может быть множество запросов) за 1 секунду.

Например, транзакция «вход в личный кабинет» включает следующие запросы: открытие главной страницы, ввод логина, пароля, нажатие кнопки «отправить», переадресацию на приветственную страницу — в единицу времени. В Gatling график можно получить лишь с помощью применения Grafana, так как для групп в HTML-отчёте строятся графики лишь по времени отклика.

| MF LoadRunner — Transactions per Second |  |

| Для расширенного пакета Apache JMeter — Transactions per Second |  |

График Errors

Обычно измеряется в rate (штук в секунду) — график показывает рост количества ошибочных запросов. Также удобно измерять значение в процентах от общего числа запросов. По этому графику отслеживается выход за пределы SLA по количеству или проценту ошибок.

Если наложить график Response Time, можно увидеть, как увеличение ошибок влияет на рост времени ответа приложения.

Gatling по умолчанию не имеет отдельного графика, отображающего лишь ошибки. В Gatling он совмещен с графиком VU и сразу показывает, как рост нагрузки сказывается на росте числа ошибок, и помогает обнаружить порог, с которого идет превышение SLA или вообще появляются ошибки. В Apache JMeter также нет отдельного графика, он совмещен с графиками количества транзакций.

| HTML Gatling Report |  |

| В MF LoadRunner этот график называется Errors per Second |  |

HTTP responses status

Возможно также выводить на график распределения количества ошибок по кодам ответа приложения — удобно использовать для классификации ошибок.